kartu nvidia cuda. CUDA Kami Menggulung: Teknologi NVIDIA CUDA. Konversi video, penyaringan audio

Mari kita kembali ke sejarah - kembali ke tahun 2003, ketika Intel dan AMD berada dalam perlombaan bersama untuk prosesor yang paling kuat. Hanya dalam beberapa tahun, kecepatan clock telah meningkat secara signifikan sebagai hasil dari perlombaan ini, terutama setelah rilis Intel Pentium 4.

Tapi balapan dengan cepat mendekati batas. Setelah gelombang peningkatan besar dalam kecepatan clock (antara 2001 dan 2003, kecepatan clock Pentium 4 berlipat ganda dari 1,5 menjadi 3 GHz), pengguna harus puas dengan sepersepuluh gigahertz yang dapat diperas oleh produsen (dari 2003 hingga 2005 , kecepatan clock meningkat dari hanya 3 menjadi 3,8 GHz).

Bahkan arsitektur yang dioptimalkan untuk kecepatan clock tinggi, seperti Prescott, mulai mengalami kesulitan, dan kali ini tidak hanya yang produksi. Pembuat chip baru saja melanggar hukum fisika. Beberapa analis bahkan meramalkan bahwa hukum Moore akan berhenti beroperasi. Tapi itu tidak terjadi. Arti asli dari hukum sering disalahartikan, tetapi mengacu pada jumlah transistor pada permukaan inti silikon. Untuk waktu yang lama, peningkatan jumlah transistor dalam CPU disertai dengan peningkatan kinerja yang sesuai - yang menyebabkan distorsi makna. Tapi kemudian situasinya menjadi lebih rumit. Perancang arsitektur CPU mendekati hukum pengurangan gain: jumlah transistor yang perlu ditambahkan untuk peningkatan kinerja yang diinginkan menjadi semakin banyak, yang mengarah ke jalan buntu.

|

Sementara pembuat CPU telah berusaha keras mencari solusi untuk masalah mereka, pembuat GPU terus mendapat manfaat luar biasa dari manfaat Hukum Moore.

Mengapa mereka tidak berakhir di jalan buntu yang sama dengan para perancang arsitektur CPU? Alasannya sangat sederhana: CPU dirancang untuk mendapatkan kinerja terbaik pada aliran instruksi yang memproses data yang berbeda (baik bilangan bulat dan angka floating point), melakukan akses memori acak, dan sebagainya. Sampai sekarang, pengembang telah mencoba untuk menyediakan paralelisme instruksi yang lebih besar - yaitu, untuk mengeksekusi instruksi sebanyak mungkin secara paralel. Jadi, misalnya, eksekusi superskalar muncul dengan Pentium, ketika dalam kondisi tertentu dimungkinkan untuk mengeksekusi dua instruksi per jam. Pentium Pro menerima eksekusi instruksi yang tidak sesuai pesanan, yang memungkinkan untuk mengoptimalkan kinerja unit komputasi. Masalahnya adalah bahwa eksekusi paralel dari aliran instruksi berurutan memiliki batasan yang jelas, sehingga meningkatkan jumlah unit komputasi secara membabi buta tidak memberikan keuntungan, karena sebagian besar waktu mereka masih akan menganggur.

Sebaliknya, pekerjaan GPU relatif sederhana. Ini terdiri dari mengambil sekelompok poligon di satu sisi dan menghasilkan sekelompok piksel di sisi lain. Poligon dan piksel tidak tergantung satu sama lain, sehingga dapat diproses secara paralel. Jadi, di GPU, dimungkinkan untuk mengalokasikan sebagian besar kristal untuk unit komputasi, yang, tidak seperti CPU, akan benar-benar digunakan.

|

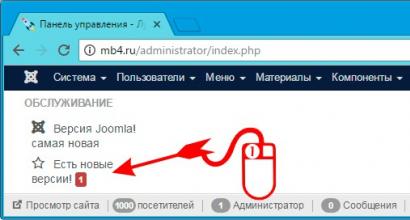

Klik pada gambar untuk memperbesar.

GPU berbeda dari CPU tidak hanya dalam hal ini. Akses memori di GPU sangat digabungkan - jika texel dibaca, maka setelah beberapa siklus, texel tetangga akan dibaca; ketika sebuah piksel ditulis, piksel tetangga akan ditulis setelah beberapa siklus. Dengan mengatur memori secara cerdas, Anda bisa mendapatkan kinerja yang mendekati bandwidth teoritis. Ini berarti bahwa GPU, tidak seperti CPU, tidak memerlukan cache yang besar, karena perannya adalah untuk mempercepat operasi texturing. Yang diperlukan hanyalah beberapa kilobyte yang berisi beberapa texel yang digunakan dalam filter bilinear dan trilinear.

|

Klik pada gambar untuk memperbesar.

Hidup GeForce FX!

Kedua dunia tetap terpisah untuk waktu yang lama. Kami menggunakan CPU (atau bahkan beberapa CPU) untuk tugas kantor dan aplikasi Internet, dan GPU hanya cocok untuk mempercepat rendering. Tetapi satu fitur mengubah segalanya: yaitu, munculnya GPU yang dapat diprogram. Pada awalnya, CPU tidak perlu takut. Yang pertama disebut GPU yang dapat diprogram (NV20 dan R200) hampir tidak menjadi ancaman. Jumlah instruksi dalam program tetap terbatas pada sekitar 10, mereka bekerja pada tipe data yang sangat eksotis, seperti angka titik tetap 9 atau 12-bit.

|

Klik pada gambar untuk memperbesar.

Namun hukum Moore kembali menunjukkan sisi terbaiknya. Peningkatan jumlah transistor tidak hanya meningkatkan jumlah unit komputasi, tetapi juga meningkatkan fleksibilitasnya. Munculnya NV30 dapat dianggap sebagai langkah maju yang signifikan karena beberapa alasan. Tentu saja, para gamer tidak terlalu menyukai kartu NV30, tetapi GPU baru mulai mengandalkan dua fitur yang dirancang untuk mengubah persepsi GPU sebagai lebih dari sekadar akselerator grafis.

- Dukungan untuk perhitungan floating-point presisi tunggal (meskipun tidak sesuai dengan standar IEEE754);

- dukungan untuk lebih dari seribu instruksi.

Jadi kami mendapatkan semua kondisi yang dapat menarik para peneliti perintis yang selalu mencari daya komputasi tambahan.

Gagasan menggunakan akselerator grafis untuk perhitungan matematis bukanlah hal baru. Upaya pertama dilakukan pada tahun 90-an abad terakhir. Tentu saja, mereka sangat primitif - terbatas, sebagian besar, untuk penggunaan beberapa fitur berbasis perangkat keras, seperti rasterisasi dan buffer-Z untuk mempercepat tugas seperti pencarian rute atau keluaran diagram Voronoi .

|

Klik pada gambar untuk memperbesar.

Pada tahun 2003, dengan munculnya shader yang berevolusi, bilah baru tercapai - kali ini melakukan perhitungan matriks. Ini adalah tahun di mana seluruh bagian SIGGRAPH ("Komputasi pada GPU") didedikasikan untuk area baru TI. Inisiatif awal ini disebut GPGPU (General-Purpose Computing pada GPU). Dan munculnya .

Untuk memahami peran BrookGPU, Anda perlu memahami bagaimana segala sesuatu terjadi sebelum kemunculannya. Satu-satunya cara untuk mendapatkan sumber daya GPU pada tahun 2003 adalah dengan menggunakan salah satu dari dua API grafis - Direct3D atau OpenGL. Akibatnya, pengembang yang ingin mendapatkan kekuatan GPU untuk komputasi mereka harus bergantung pada dua API yang disebutkan. Masalahnya adalah mereka tidak selalu ahli dalam pemrograman kartu grafis, dan ini membuat akses ke teknologi menjadi sangat sulit. Jika pemrogram 3D beroperasi dengan shader, tekstur, dan fragmen, maka spesialis di bidang pemrograman paralel mengandalkan utas, inti, penghambur, dll. Oleh karena itu, pada awalnya perlu untuk menarik analogi antara dua dunia.

- sungai kecil adalah aliran elemen dari jenis yang sama, di GPU dapat diwakili oleh tekstur. Pada prinsipnya, dalam pemrograman klasik ada analog seperti array.

- Inti- fungsi yang akan diterapkan secara independen ke setiap elemen aliran; adalah setara dengan pixel shader. Dalam pemrograman klasik, Anda dapat memberikan analogi untuk sebuah siklus - ini diterapkan pada sejumlah besar elemen.

- Untuk membaca hasil penerapan kernel ke aliran, tekstur harus dibuat. Tidak ada yang setara pada CPU karena ada akses memori penuh.

- Lokasi di memori yang akan ditulisi (dalam operasi scatter/scatter) dikendalikan melalui vertex shader, karena pixel shader tidak dapat mengubah koordinat piksel yang diproses.

Seperti yang Anda lihat, bahkan dengan mempertimbangkan analogi di atas, tugasnya tidak terlihat sederhana. Dan Brook datang untuk menyelamatkan. Nama ini mengacu pada ekstensi ke bahasa C ("C dengan aliran", "C dengan aliran"), sebagaimana disebut oleh para pengembang di Stanford. Pada intinya, tugas Brook adalah menyembunyikan semua komponen API 3D dari programmer, yang memungkinkan untuk menghadirkan GPU sebagai koprosesor untuk komputasi paralel. Untuk melakukan ini, kompiler Brook memproses file .br dengan kode dan ekstensi C++, lalu menghasilkan kode C++ yang ditautkan ke pustaka dengan dukungan untuk keluaran yang berbeda (DirectX, OpenGL ARB, OpenGL NV3x, x86).

|

Klik pada gambar untuk memperbesar.

Brook memiliki beberapa penghargaan, yang pertama adalah membawa GPGPU keluar dari bayang-bayang sehingga teknologinya dapat dilihat oleh masyarakat umum. Meski, setelah pengumuman proyek tersebut, sejumlah situs IT terlalu optimis bahwa rilis Brook meragukan keberadaan CPU, yang akan segera digantikan oleh GPU yang lebih kuat. Tapi, seperti yang kita lihat, bahkan setelah lima tahun ini tidak terjadi. Sejujurnya, kami tidak berpikir itu akan pernah terjadi sama sekali. Di sisi lain, melihat keberhasilan evolusi CPU, yang semakin berorientasi paralelisme (lebih banyak core, teknologi multithreading SMT, perluasan blok SIMD), serta GPU, yang, sebaliknya, menjadi lebih universal (mendukung untuk perhitungan floating point). presisi tunggal, perhitungan bilangan bulat, dukungan untuk perhitungan presisi ganda), sepertinya GPU dan CPU akan segera bergabung. Apa yang akan terjadi kemudian? Apakah GPU akan ditelan oleh CPU, seperti yang terjadi pada koprosesor matematika? Cukup mungkin. Intel dan AMD sedang mengerjakan proyek serupa hari ini. Tapi masih banyak yang bisa berubah.

Tapi kembali ke topik kita. Keuntungan Brook adalah mempopulerkan konsep GPGPU, ini sangat menyederhanakan akses ke sumber daya GPU, yang memungkinkan semakin banyak pengguna untuk menguasai model pemrograman baru. Di sisi lain, terlepas dari semua kualitas Brook, masih ada jalan panjang sebelum sumber daya GPU dapat digunakan untuk komputasi.

Salah satu masalah terkait dengan tingkat abstraksi yang berbeda, dan juga, khususnya, beban tambahan berlebihan yang dibuat oleh API 3D, yang bisa sangat terlihat. Tetapi yang lebih serius dapat dianggap sebagai masalah kompatibilitas, di mana pengembang Brook tidak dapat melakukan apa pun. Ada persaingan sengit antara produsen GPU, sehingga mereka sering mengoptimalkan driver mereka. Jika pengoptimalan seperti itu, sebagian besar, bagus untuk para gamer, mereka dapat menghilangkan kompatibilitas Brook dalam sekejap. Oleh karena itu, sulit membayangkan penggunaan API ini dalam kode industri yang akan berfungsi di suatu tempat. Dan untuk waktu yang lama, Brook tetap menjadi peneliti dan pemrogram amatir.

Namun, keberhasilan Brook cukup menarik perhatian ATI dan Nvidia, dan mereka tertarik dengan inisiatif seperti itu, karena dapat memperluas pasar, membuka sektor penting baru bagi perusahaan.

Para peneliti yang awalnya terlibat dalam proyek Brook dengan cepat bergabung dengan tim pengembangan di Santa Clara untuk mempresentasikan strategi global untuk mengembangkan pasar baru. Idenya adalah untuk membuat kombinasi perangkat keras dan perangkat lunak yang cocok untuk tugas GPGPU. Karena pengembang nVidia mengetahui semua rahasia GPU mereka, dimungkinkan untuk tidak mengandalkan API grafis, tetapi untuk berkomunikasi dengan prosesor grafis melalui driver. Meskipun, tentu saja, ini datang dengan masalahnya sendiri. Jadi, tim pengembangan CUDA (Compute Unified Device Architecture) telah membuat satu set lapisan perangkat lunak untuk bekerja dengan GPU.

|

Klik pada gambar untuk memperbesar.

Seperti yang Anda lihat dalam diagram, CUDA menyediakan dua API.

- API tingkat tinggi: CUDA Runtime API;

- API tingkat rendah: CUDA Driver API.

Karena API tingkat tinggi diimplementasikan di atas API tingkat rendah, setiap panggilan fungsi runtime dipecah menjadi instruksi sederhana yang diproses oleh Driver API. Perhatikan bahwa kedua API tersebut saling eksklusif: seorang programmer dapat menggunakan satu atau API lainnya, tetapi tidak mungkin untuk mencampur pemanggilan fungsi dari kedua API tersebut. Secara umum, istilah "API tingkat tinggi" bersifat relatif. Bahkan API Runtime sedemikian rupa sehingga banyak orang akan menganggapnya tingkat rendah; namun, ia masih menyediakan fungsi yang sangat nyaman untuk inisialisasi atau manajemen konteks. Tapi jangan berharap tingkat abstraksi yang sangat tinggi - Anda masih harus memiliki pengetahuan yang baik tentang GPU nVidia dan cara kerjanya.

Driver API bahkan lebih sulit untuk digunakan; Anda membutuhkan lebih banyak upaya untuk menjalankan pemrosesan GPU. Di sisi lain, API tingkat rendah lebih fleksibel, memberi programmer lebih banyak kontrol jika diperlukan. Dua API mampu bekerja dengan sumber daya OpenGL atau Direct3D (hanya versi kesembilan pada hari ini). Manfaat fitur ini jelas - CUDA dapat digunakan untuk membuat sumber daya (geometri, tekstur prosedural, dll.) yang dapat diteruskan ke API grafis atau, sebaliknya, API 3D dapat dibuat untuk mengirim hasil rendering ke CUDA program, yang, pada gilirannya, akan melakukan pasca-pemrosesan. Ada banyak contoh interaksi seperti itu, dan keuntungannya adalah bahwa sumber daya terus disimpan dalam memori GPU, mereka tidak perlu ditransfer melalui bus PCI Express, yang masih menjadi hambatan.

Namun, perlu dicatat bahwa berbagi sumber daya dalam memori video tidak selalu ideal dan dapat menyebabkan beberapa "sakit kepala". Misalnya, saat mengubah resolusi atau kedalaman warna, data grafis diutamakan. Oleh karena itu, jika diperlukan untuk meningkatkan sumber daya dalam buffer bingkai, maka driver akan dengan mudah melakukan ini dengan mengorbankan sumber daya aplikasi CUDA, yang hanya akan macet dengan kesalahan. Tentu saja, tidak terlalu elegan, tetapi situasi ini seharusnya tidak terlalu sering terjadi. Dan karena kami mulai berbicara tentang kerugiannya: jika Anda ingin menggunakan beberapa GPU untuk aplikasi CUDA, maka Anda harus terlebih dahulu menonaktifkan mode SLI, jika tidak, aplikasi CUDA hanya akan dapat "melihat" satu GPU.

Akhirnya, tingkat perangkat lunak ketiga diberikan ke perpustakaan - dua, tepatnya.

- CUBLAS, yang berisi blok yang diperlukan untuk menghitung aljabar linier pada GPU;

- Cufft, yang mendukung perhitungan transformasi Fourier, adalah algoritma yang banyak digunakan di bidang pemrosesan sinyal.

Sebelum kita masuk ke CUDA, mari kita definisikan beberapa istilah yang tersebar di seluruh dokumentasi nVidia. Perusahaan telah memilih terminologi yang sangat spesifik yang sulit untuk digunakan. Pertama-tama, kami perhatikan bahwa benang di CUDA tidak memiliki arti yang sama dengan utas CPU, juga tidak setara dengan utas di artikel GPU kami. Utas GPU dalam hal ini adalah kumpulan data dasar yang perlu diproses. Tidak seperti utas CPU, utas CUDA sangat "ringan", artinya sakelar konteks di antara dua utas sama sekali bukan operasi intensif sumber daya.

Istilah kedua yang sering ditemukan dalam dokumentasi CUDA adalah melengkung. Tidak ada kebingungan di sini, karena tidak ada analog dalam bahasa Rusia (kecuali jika Anda adalah penggemar game Start Trek atau Warhammer). Padahal, istilah ini diambil dari industri tekstil, di mana benang pakan ditarik melalui benang lusi, yang direntangkan pada alat tenun. Warp di CUDA adalah sekelompok 32 utas dan merupakan jumlah minimum data yang diproses dengan cara SIMD di multiprosesor CUDA.

Tetapi "kekasaran" seperti itu tidak selalu nyaman bagi programmer. Oleh karena itu, di CUDA, alih-alih bekerja dengan warps secara langsung, Anda dapat bekerja dengan memblokir, berisi 64 hingga 512 utas.

Akhirnya, balok-balok ini disatukan dalam kisi-kisi. Keuntungan dari pengelompokan ini adalah jumlah blok yang diproses oleh GPU pada saat yang sama berkaitan erat dengan sumber daya perangkat keras, seperti yang akan kita lihat di bawah. Mengelompokkan blok ke dalam kisi memungkinkan Anda untuk sepenuhnya abstrak dari batasan ini dan menerapkan kernel / kernel ke lebih banyak utas dalam satu panggilan, tanpa memikirkan sumber daya tetap. Perpustakaan CUDA bertanggung jawab untuk semua ini. Selain itu, model ini berskala dengan baik. Jika GPU kekurangan sumber daya, maka GPU akan mengeksekusi blok secara berurutan. Jika jumlah prosesor komputasi besar, maka blok dapat dieksekusi secara paralel. Artinya, kode yang sama dapat berjalan pada GPU entry-level dan model top-end dan bahkan di masa mendatang.

Ada beberapa istilah lagi di CUDA API yang merupakan singkatan dari CPU ( tuan rumah / tuan rumah) dan GPU ( perangkat/perangkat). Jika perkenalan kecil ini tidak membuat Anda takut, maka inilah saatnya untuk mengenal CUDA lebih baik.

Jika Anda sering membaca Tom's Hardware Guide, maka arsitektur GPU terbaru dari nVidia sudah tidak asing lagi bagi Anda. Jika belum, kami sarankan Anda membaca artikel " nVidia GeForce GTX 260 dan 280: kartu grafis generasi baru". Berkenaan dengan CUDA, nVidia menyajikan arsitektur yang sedikit berbeda, menunjukkan beberapa detail yang sebelumnya tersembunyi.

Seperti yang Anda lihat dari ilustrasi di atas, inti shader nVidia terdiri dari beberapa kelompok prosesor tekstur. (Kluster Prosesor Tekstur, TPC). 8800 GTX, misalnya, menggunakan delapan cluster, 8800 GTS menggunakan enam, dan seterusnya. Setiap cluster pada dasarnya terdiri dari unit tekstur dan dua streaming multiprosesor. Yang terakhir termasuk awal pipa (ujung depan), yang membaca dan mendekode instruksi, serta mengirimkannya untuk dieksekusi, dan akhir pipa (ujung belakang), yang terdiri dari delapan perangkat komputasi dan dua perangkat superfungsional. SFU (Unit Fungsi Super), di mana instruksi dieksekusi sesuai dengan prinsip SIMD, yaitu, satu instruksi diterapkan ke semua utas di warp. nVidia menyebut cara melakukannya SIMT(satu instruksi banyak utas, satu instruksi, banyak utas). Penting untuk dicatat bahwa ujung pipa beroperasi pada dua kali frekuensi awalnya. Dalam praktiknya, ini berarti bahwa bagian tersebut terlihat dua kali lebih "lebar" daripada yang sebenarnya (yaitu seperti blok SIMD 16 saluran, bukan yang delapan saluran). Multiprosesor streaming bekerja seperti ini: setiap siklus, awal pipeline memilih warp yang siap dieksekusi dan mulai mengeksekusi instruksi. Agar instruksi diterapkan ke semua 32 utas di warp, akhir pipa akan membutuhkan empat siklus clock, tetapi karena berjalan pada dua kali frekuensi awal, itu hanya akan membutuhkan dua siklus clock (dalam hal awal pipa). Oleh karena itu, agar awal pipa tidak menganggur selama satu siklus, dan perangkat keras dimuat secara maksimal, dalam kasus yang ideal, Anda dapat mengganti instruksi setiap siklus - instruksi klasik dalam satu siklus dan instruksi untuk SFU - di siklus lain .

Setiap multiprosesor memiliki seperangkat sumber daya tertentu yang layak untuk dipahami. Ada area kecil di memori yang disebut "Berbagi memori", 16 KB per multiprosesor. Ini sama sekali bukan memori cache: programmer dapat menggunakannya sesuai kebijaksanaannya. Artinya, kami memiliki sesuatu yang dekat dengan Toko Lokal SPU pada prosesor Sel. Detail ini cukup menarik karena menekankan bahwa CUDA merupakan kombinasi dari teknologi perangkat lunak dan perangkat keras. Area memori ini tidak digunakan untuk pixel shader, karena Nvidia dengan cerdik menunjukkan "kami tidak suka ketika piksel berbicara satu sama lain".

Area memori ini membuka kemungkinan pertukaran informasi antar utas. dalam satu blok. Penting untuk menekankan batasan ini: semua utas dalam satu blok dijamin akan dieksekusi oleh multiprosesor tunggal. Sebaliknya, pengikatan blok ke multiprosesor yang berbeda tidak ditetapkan sama sekali, dan dua utas dari blok yang berbeda tidak dapat bertukar informasi satu sama lain selama eksekusi. Artinya, menggunakan memori bersama tidak sesederhana itu. Namun, memori bersama masih dibenarkan, kecuali ketika beberapa utas mencoba mengakses bank memori yang sama, menyebabkan konflik. Dalam situasi lain, akses memori bersama secepat akses register.

Memori bersama bukan satu-satunya yang dapat diakses oleh multiprosesor. Mereka dapat menggunakan memori video, tetapi dengan bandwidth yang lebih rendah dan latensi yang lebih tinggi. Oleh karena itu, untuk mengurangi frekuensi mengakses memori ini, nVidia melengkapi multiprosesor dengan cache (sekitar 8 KB per multiprosesor) yang menyimpan konstanta dan tekstur.

Multiprosesor memiliki 8.192 register yang umum untuk semua utas dari semua blok yang aktif pada multiprosesor. Jumlah blok aktif per multiprosesor tidak boleh melebihi delapan, dan jumlah warps aktif dibatasi hingga 24 (768 utas). Oleh karena itu, 8800 GTX dapat memproses hingga 12.288 utas sekaligus. Semua batasan ini layak disebutkan karena memungkinkan algoritme dioptimalkan berdasarkan sumber daya yang tersedia.

Optimalisasi program CUDA, oleh karena itu, terdiri dari memperoleh keseimbangan optimal antara jumlah blok dan ukurannya. Lebih banyak utas per blok akan membantu dalam mengurangi latensi memori, tetapi jumlah register yang tersedia per utas juga akan berkurang. Selain itu, blok 512 utas tidak akan efisien, karena hanya satu blok yang dapat aktif pada multiprosesor, yang mengakibatkan hilangnya 256 utas. Oleh karena itu, nVidia merekomendasikan penggunaan blok 128 atau 256 utas, yang memberikan kompromi terbaik antara latensi yang lebih rendah dan jumlah register untuk sebagian besar inti/kernel.

Dari sudut pandang program, CUDA terdiri dari satu set ekstensi ke bahasa C, yang menyerupai BrookGPU, serta beberapa panggilan API tertentu. Di antara ekstensi adalah penentu tipe yang terkait dengan fungsi dan variabel. Penting untuk mengingat kata kunci __global__, yang, ketika diberikan di depan fungsi, menunjukkan bahwa yang terakhir mengacu pada kernel / kernel - fungsi ini akan dipanggil oleh CPU, dan akan dijalankan pada GPU. Awalan __perangkat__ menentukan bahwa fungsi tersebut akan dijalankan pada GPU (yang CUDA menyebutnya sebagai "perangkat/perangkat") tetapi hanya dapat dipanggil dari GPU (dengan kata lain, dari fungsi __device__ lain atau dari fungsi __global__). Akhirnya, awalan __tuan rumah__ opsional, ini menunjukkan fungsi yang dipanggil oleh CPU dan dijalankan oleh CPU - dengan kata lain, fungsi biasa.

Ada sejumlah batasan yang terkait dengan fungsi __device__ dan __global__: mereka tidak dapat rekursif (yaitu, menyebut diri mereka sendiri), dan mereka tidak dapat memiliki sejumlah argumen yang bervariasi. Terakhir, karena fungsi __device__ berada di ruang memori GPU, masuk akal jika alamatnya tidak dapat diambil. Variabel juga memiliki sejumlah kualifikasi yang menunjukkan lokasi memori di mana mereka akan disimpan. Variabel dengan awalan __bersama__ berarti akan disimpan dalam memori bersama dari multiprosesor streaming. Panggilan ke fungsi __global__ sedikit berbeda. Masalahnya, saat menelepon, Anda perlu mengatur konfigurasi eksekusi - lebih khusus lagi, ukuran grid / grid yang akan diterapkan kernel / kernel, serta ukuran setiap blok. Ambil, misalnya, kernel dengan tanda tangan berikut.

| __global__ void Func(parameter float*); |

Ini akan disebut sebagai

| fungsi<<< Dg, Db >>> (parameter); |

di mana Dg adalah ukuran grid dan Db adalah ukuran blok. Kedua variabel ini mengacu pada tipe vektor baru yang diperkenalkan dengan CUDA.

CUDA API berisi fungsi untuk bekerja dengan memori di VRAM: cudaMalloc untuk mengalokasikan memori, cudaFree untuk membebaskan, dan cudaMemcpy untuk menyalin memori antara RAM dan VRAM dan sebaliknya.

Kami akan mengakhiri ulasan ini dengan cara yang sangat menarik di mana program CUDA dikompilasi: kompilasi dilakukan dalam beberapa langkah. Pertama, kode khusus CPU diekstraksi dan diteruskan ke kompiler standar. Kode yang ditujukan untuk GPU pertama kali dikonversi ke bahasa perantara PTX. Ini mirip dengan bahasa rakitan dan memungkinkan Anda mempelajari kode untuk mencari bagian yang tidak efisien. Akhirnya, fase terakhir adalah menerjemahkan bahasa perantara ke dalam instruksi khusus GPU dan membuat biner.

Melihat melalui dokumentasi nVidia membuat saya ingin mencoba CUDA minggu ini. Memang, apa yang bisa lebih baik daripada mengevaluasi API dengan membuat program Anda sendiri? Saat itulah sebagian besar masalah harus muncul ke permukaan, bahkan jika semuanya terlihat sempurna di atas kertas. Selain itu, praktik terbaik akan menunjukkan seberapa baik Anda memahami semua prinsip yang diuraikan dalam dokumentasi CUDA.

Sangat mudah untuk terjun ke proyek semacam itu. Saat ini, sejumlah besar alat gratis, tetapi berkualitas tinggi tersedia untuk diunduh. Untuk pengujian kami, kami menggunakan Visual C++ Express 2005, yang memiliki semua yang Anda butuhkan. Bagian tersulit adalah menemukan program yang tidak membutuhkan waktu berminggu-minggu untuk diport ke GPU, tetapi cukup menarik sehingga upaya kami tidak sia-sia. Pada akhirnya, kami memilih sepotong kode yang mengambil peta ketinggian dan menghitung peta normal yang sesuai. Kami tidak akan menyelidiki fungsi ini secara rinci, karena hampir tidak menarik dalam artikel ini. Singkatnya, program berurusan dengan kelengkungan area: untuk setiap piksel gambar awal, kami menerapkan matriks yang menentukan warna piksel yang dihasilkan dalam gambar yang dihasilkan dari piksel yang berdekatan, menggunakan rumus yang kurang lebih kompleks. Keuntungan dari fungsi ini adalah sangat mudah untuk diparalelkan, sehingga tes ini menunjukkan kemampuan CUDA dengan sempurna.

Keuntungan lain adalah bahwa kami telah memiliki implementasi pada CPU, sehingga kami dapat membandingkan hasilnya dengan versi CUDA - dan tidak menemukan kembali kemudi.

Kami ulangi sekali lagi bahwa tujuan pengujian adalah untuk berkenalan dengan utilitas CUDA SDK, dan bukan untuk membandingkan versi untuk CPU dan GPU. Karena ini adalah upaya pertama kami untuk membuat program CUDA, kami tidak terlalu mengharapkan kinerja yang tinggi. Karena bagian kode ini tidak kritis, versi CPU tidak dioptimalkan, jadi perbandingan langsung dari hasilnya hampir tidak menarik.

Pertunjukan

Namun, kami mengukur waktu eksekusi untuk melihat apakah ada keuntungan menggunakan CUDA bahkan dengan implementasi yang paling kasar, atau jika kami membutuhkan latihan yang lama dan melelahkan untuk mendapatkan keuntungan apa pun saat menggunakan GPU. Mesin uji diambil dari lab pengembangan kami - laptop dengan prosesor Core 2 Duo T5450 dan kartu grafis GeForce 8600M GT yang menjalankan Vista. Ini jauh dari superkomputer, tetapi hasilnya sangat menarik, karena pengujiannya tidak "dipertajam" untuk GPU. Itu selalu menyenangkan untuk melihat nVidia menunjukkan keuntungan besar pada sistem dengan GPU mengerikan dan banyak bandwidth, tetapi dalam prakteknya, banyak dari 70 juta CUDA-enabled GPU di pasar PC saat ini sama sekali tidak kuat, sehingga pengujian kami dibenarkan.

Untuk gambar 2048 x 2048 piksel, kami mendapatkan hasil sebagai berikut.

- CPU 1 utas: 1419ms;

- CPU 2 utas: 749ms;

- CPU 4 utas: 593ms

- GPU (8600M GT) blok 256 utas: 109ms;

- GPU (8600M GT) blok 128 thread: 94ms;

- GPU (8800 GTX) blok 128 utas / 256 utas: 31ms.

Beberapa kesimpulan dapat ditarik dari hasil tersebut. Mari kita mulai dengan fakta bahwa, terlepas dari pembicaraan tentang kemalasan yang jelas dari programmer, kami memodifikasi versi awal CPU untuk beberapa utas. Seperti yang telah kami sebutkan, kode ini ideal untuk situasi ini - yang diperlukan hanyalah membagi gambar awal menjadi zona sebanyak aliran yang ada. Perhatikan bahwa dari beralih dari satu utas ke dua utas pada CPU dual-core kami, akselerasinya hampir linier, yang juga menunjukkan sifat paralel dari program pengujian. Secara tidak terduga, versi dengan empat utas juga lebih cepat, meskipun ini sangat aneh pada prosesor kami - sebaliknya, orang dapat mengharapkan penurunan efisiensi karena biaya pengelolaan utas tambahan. Bagaimana hasil seperti itu dapat dijelaskan? Sulit untuk mengatakannya, tetapi penjadwal utas Windows mungkin adalah pelakunya; dalam hal apapun, hasilnya dapat diulang. Dengan tekstur yang lebih kecil (512x512), keuntungan dari pemisahan tidak begitu terasa (sekitar 35% berbanding 100%), dan perilaku versi empat utas lebih logis, tanpa keuntungan dibandingkan dengan versi dua utas. GPU masih lebih cepat, tetapi tidak begitu menonjol (8600M GT tiga kali lebih cepat daripada versi ulir ganda).

|

Klik pada gambar untuk memperbesar.

Pengamatan signifikan kedua adalah bahwa implementasi GPU yang paling lambat pun ternyata hampir enam kali lebih cepat daripada versi CPU dengan kinerja tertinggi. Untuk program pertama dan versi algoritma yang tidak dioptimalkan, hasilnya sangat menggembirakan. Harap dicatat bahwa kami mendapat hasil yang jauh lebih baik pada blok kecil, meskipun intuisi mungkin menyarankan sebaliknya. Penjelasannya sederhana - program kami menggunakan 14 register per utas, dan dengan 256 blok utas, diperlukan 3.584 register per blok, dan 768 utas diperlukan untuk beban prosesor penuh, seperti yang kami tunjukkan. Dalam kasus kami, ini adalah tiga blok atau 10.572 register. Tetapi multiprosesor hanya memiliki 8.192 register, sehingga hanya dapat membuat dua blok aktif. Sebaliknya, dengan blok 128 utas, kita membutuhkan 1.792 register per blok; jika 8.192 dibagi 1.792 dan dibulatkan ke bilangan bulat terdekat, kita mendapatkan empat balok. Dalam praktiknya, jumlah utas akan sama (512 per multiprosesor, meskipun 768 secara teoritis diperlukan untuk beban penuh), tetapi peningkatan jumlah blok memberi GPU keuntungan fleksibilitas dalam akses memori - saat operasi sedang berlangsung dengan penundaan yang besar, ia dapat mulai mengeksekusi instruksi dari blok lain, menunggu hasil yang diterima. Empat blok jelas mengurangi latensi, terutama karena program kami menggunakan banyak akses memori.

Analisis

Akhirnya, terlepas dari apa yang kami katakan di atas, kami tidak dapat menahan godaan dan menjalankan program pada 8800 GTX, yang tiga kali lebih cepat daripada 8600, terlepas dari ukuran bloknya. Anda mungkin berpikir bahwa dalam praktiknya, pada arsitektur yang sesuai, hasilnya akan empat kali atau lebih tinggi: 128 ALU / prosesor shader versus 32 dan kecepatan clock yang lebih tinggi (1,35 GHz versus 950 MHz), tetapi ini tidak terjadi. Kemungkinan besar, faktor pembatasnya adalah akses memori. Untuk lebih tepatnya, gambar awal diakses sebagai array CUDA multi-dimensi - istilah yang agak rumit untuk sesuatu yang tidak lebih dari tekstur. Tapi makan beberapa manfaat.

- mengakses manfaat dari cache tekstur;

- kami menggunakan mode pembungkus, yang tidak perlu menangani batas gambar, tidak seperti versi CPU.

Selain itu, kita dapat memperoleh manfaat dari pemfilteran "gratis" dengan pengalamatan yang dinormalisasi antara alih-alih dan , tetapi ini hampir tidak berguna dalam kasus kita. Seperti yang Anda ketahui, 8600 memiliki 16 unit tekstur, dibandingkan dengan 32 untuk 8800 GTX. Oleh karena itu, rasio antara dua arsitektur hanya dua banding satu. Tambahkan ke perbedaan frekuensi dan kami mendapatkan rasio (32 x 0,575) / (16 x 0,475) = 2,4 - mendekati "tiga banding satu" yang sebenarnya kami dapatkan. Teori ini juga menjelaskan mengapa ukuran blok tidak banyak berubah pada G80, karena ALU masih bertumpu pada unit tekstur.

|

Klik pada gambar untuk memperbesar.

Selain hasil yang menjanjikan, pertemuan pertama kami dengan CUDA berjalan sangat baik, mengingat kondisi yang dipilih tidak terlalu menguntungkan. Mengembangkan pada laptop Vista berarti menggunakan CUDA SDK 2.0, yang masih dalam versi beta, dengan driver 174.55, yang juga dalam versi beta. Meskipun demikian, kami tidak dapat melaporkan kejutan yang tidak menyenangkan - hanya kesalahan awal selama debugging pertama, ketika program kami, masih sangat "berjalan", mencoba mengatasi memori di luar ruang yang dialokasikan.

Monitor mulai berkedip-kedip liar, kemudian layar menjadi hitam...sampai Vista menjalankan layanan perbaikan driver dan semuanya baik-baik saja. Tetapi masih agak mengejutkan untuk melihat apakah Anda terbiasa melihat Segmentation Fault yang khas pada program standar seperti milik kami. Akhirnya, kritik kecil terhadap nVidia: di semua dokumentasi yang tersedia untuk CUDA, tidak ada panduan kecil yang akan memandu Anda langkah demi langkah tentang cara menyiapkan lingkungan pengembangan untuk Visual Studio. Sebenarnya, masalahnya tidak besar, karena SDK memiliki serangkaian contoh lengkap yang dapat dipelajari untuk memahami kerangka kerja untuk aplikasi CUDA, tetapi panduan pemula akan lebih baik.

|

Klik pada gambar untuk memperbesar.

Nvidia memperkenalkan CUDA dengan merilis GeForce 8800. Dan pada saat itu janji-janji itu tampak sangat menggiurkan, tetapi kami tetap antusias untuk ujian yang sebenarnya. Memang, pada saat itu sepertinya lebih seperti menandai wilayah untuk tetap berada di gelombang GPGPU. Tanpa SDK yang tersedia, sulit untuk mengatakan bahwa kami tidak menghadapi dummy pemasaran lain yang tidak akan berfungsi. Ini bukan pertama kalinya inisiatif yang baik diumumkan terlalu dini dan pada saat itu tidak terungkap karena kurangnya dukungan - terutama di sektor yang begitu kompetitif. Sekarang, satu setengah tahun setelah pengumuman, kita dapat dengan aman mengatakan bahwa nVidia telah menepati janjinya.

SDK masuk ke beta cukup cepat pada awal 2007, dan telah diperbarui dengan cepat sejak saat itu, membuktikan pentingnya proyek ini untuk nVidia. Saat ini, CUDA berkembang dengan sangat baik: SDK sudah tersedia dalam versi beta 2.0 untuk sistem operasi utama (Windows XP dan Vista, Linux, serta 1.1 untuk Mac OS X), dan nVidia telah mendedikasikan seluruh bagian situs untuk pengembang.

Di tingkat yang lebih profesional, kesan langkah awal bersama CUDA ternyata sangat positif. Bahkan jika Anda terbiasa dengan arsitektur GPU, Anda dapat dengan mudah mengetahuinya. Ketika API terlihat jelas pada pandangan pertama, Anda segera mulai percaya bahwa Anda akan mendapatkan hasil yang meyakinkan. Tetapi bukankah waktu komputasi akan terbuang sia-sia dari beberapa transfer dari CPU ke GPU? Dan bagaimana cara menggunakan ribuan utas ini dengan hampir tidak ada sinkronisasi primitif? Kami memulai eksperimen kami dengan semua ketakutan ini dalam pikiran. Tetapi mereka dengan cepat menghilang ketika versi pertama dari algoritme kami, meskipun sangat sepele, ternyata jauh lebih cepat daripada di CPU.

Jadi CUDA bukanlah penyelamat bagi para peneliti yang ingin meyakinkan pejabat universitas untuk membelikan mereka GeForce. CUDA sudah merupakan teknologi yang tersedia sepenuhnya yang dapat digunakan oleh programmer C mana pun jika mereka bersedia meluangkan waktu dan upaya untuk membiasakan diri dengan paradigma pemrograman baru. Upaya ini tidak akan sia-sia jika algoritme Anda diparalelkan dengan baik. Kami juga ingin berterima kasih kepada nVidia karena telah menyediakan dokumentasi yang lengkap dan berkualitas tinggi, di mana para programmer CUDA pemula akan menemukan jawabannya.

Apa yang diperlukan CUDA untuk menjadi API yang dapat dikenali? Dalam satu kata: portabilitas. Kita tahu bahwa masa depan TI terletak pada komputasi paralel - hari ini semua orang sudah bersiap untuk perubahan tersebut, dan semua inisiatif, baik perangkat lunak maupun perangkat keras, diarahkan ke arah ini. Namun, saat ini, jika Anda melihat perkembangan paradigma, kami masih pada tahap awal: kami membuat utas secara manual dan mencoba menjadwalkan akses ke sumber daya bersama; semua ini entah bagaimana bisa diatasi jika jumlah core dapat dihitung dengan jari satu tangan. Namun dalam beberapa tahun, ketika jumlah prosesor akan mencapai ratusan, kemungkinan ini tidak akan ada lagi. Dengan dirilisnya CUDA, nVidia mengambil langkah pertama dalam memecahkan masalah ini - tetapi, tentu saja, solusi ini hanya cocok untuk GPU dari perusahaan ini, dan itupun tidak untuk semua orang. Hanya GF8 dan 9 (dan turunan Quadro/Tesla mereka) yang dapat menjalankan program CUDA hari ini. Dan baris baru 260/280, tentu saja.

|

Klik pada gambar untuk memperbesar.

Nvidia mungkin membanggakan bahwa ia telah menjual 70 juta GPU yang kompatibel dengan CUDA di seluruh dunia, tetapi itu masih belum cukup untuk menjadi standar de facto. Mempertimbangkan fakta bahwa pesaing tidak tinggal diam. AMD menawarkan SDK (Stream Computing) sendiri, dan Intel telah mengumumkan solusi (Ct), meskipun belum tersedia. Perang standar akan datang, dan jelas tidak akan ada ruang di pasar untuk tiga pesaing sampai pemain lain seperti Microsoft keluar dengan proposal API umum, yang tentu saja akan membuat hidup lebih mudah bagi pengembang.

Oleh karena itu, nVidia memiliki banyak kesulitan dalam hal persetujuan CUDA. Meskipun secara teknologi kami memiliki solusi yang sukses di hadapan kami, tanpa diragukan lagi, tetap meyakinkan para pengembang tentang prospeknya - dan ini tidak akan mudah. Namun, dilihat dari banyaknya pengumuman dan berita API baru-baru ini, masa depan tidak terlihat suram sama sekali.

Perangkat untuk mengubah komputer pribadi menjadi superkomputer kecil telah dikenal sejak lama. Kembali di tahun 80-an abad terakhir, yang disebut transputer ditawarkan di pasar, yang dimasukkan ke dalam slot ekspansi ISA yang umum. Pada awalnya, kinerja mereka dalam tugas yang sesuai sangat mengesankan, tetapi kemudian pertumbuhan kinerja prosesor universal dipercepat, mereka memperkuat posisi mereka dalam komputasi paralel, dan tidak ada gunanya transputer. Meskipun perangkat tersebut masih ada, mereka adalah berbagai akselerator khusus. Namun seringkali cakupan aplikasinya sempit dan akselerator semacam itu tidak banyak digunakan.

Namun baru-baru ini, tongkat estafet komputasi paralel telah pindah ke pasar massal, dengan satu atau lain cara terhubung dengan game tiga dimensi. Perangkat serba guna dengan prosesor multi-inti untuk komputasi vektor paralel yang digunakan dalam grafik 3D mencapai kinerja puncak tinggi yang tidak dapat dilakukan oleh prosesor serba guna. Tentu saja, kecepatan maksimum hanya dicapai dalam sejumlah tugas yang nyaman dan memiliki beberapa batasan, tetapi perangkat semacam itu sudah mulai digunakan secara luas di area yang awalnya tidak dimaksudkan. Contoh luar biasa dari prosesor paralel semacam itu adalah prosesor Sel yang dikembangkan oleh aliansi Sony-Toshiba-IBM dan digunakan di konsol game Sony PlayStation 3, serta semua kartu video modern dari para pemimpin pasar - Nvidia dan AMD.

Kami tidak akan menyentuh Cell hari ini, meskipun itu muncul sebelumnya dan merupakan prosesor universal dengan kemampuan vektor tambahan, kami tidak membicarakannya hari ini. Untuk akselerator video 3D, teknologi komputasi non-grafis serba guna pertama GPGPU (Komputasi Tujuan Umum pada GPU) muncul beberapa tahun lalu. Bagaimanapun, chip video modern berisi ratusan unit eksekusi matematis, dan kekuatan ini dapat digunakan untuk mempercepat banyak aplikasi intensif komputasi secara signifikan. Dan generasi GPU saat ini memiliki arsitektur yang cukup fleksibel yang, bersama dengan bahasa pemrograman tingkat tinggi dan arsitektur perangkat keras-perangkat lunak seperti yang dibahas dalam artikel ini, membuka kemungkinan ini dan membuatnya lebih mudah diakses.

Penciptaan GPCPU didorong oleh munculnya program shader yang cukup cepat dan fleksibel yang mampu mengeksekusi chip video modern. Pengembang memutuskan untuk membuat GPU menghitung tidak hanya gambar dalam aplikasi 3D, tetapi juga digunakan dalam perhitungan paralel lainnya. GPGPU menggunakan API grafis untuk ini: OpenGL dan Direct3D, ketika data ditransfer ke chip video dalam bentuk tekstur, dan program kalkulasi dimuat dalam bentuk shader. Kekurangan dari metode ini adalah kompleksitas pemrograman yang relatif tinggi, kecepatan pertukaran data yang rendah antara CPU dan GPU, dan keterbatasan lainnya, yang akan kita bahas nanti.

Komputasi GPU telah berkembang dan berkembang sangat pesat. Dan selanjutnya, dua produsen chip video besar, Nvidia dan AMD, mengembangkan dan mengumumkan masing-masing platform yang disebut CUDA (Compute Unified Device Architecture) dan CTM (Close To Metal atau AMD Stream Computing). Tidak seperti model pemrograman GPU sebelumnya, ini dilakukan dengan akses langsung ke kemampuan perangkat keras kartu grafis. Platform tidak kompatibel satu sama lain, CUDA adalah perpanjangan dari bahasa pemrograman C, dan CTM adalah mesin virtual yang mengeksekusi kode perakitan. Namun kedua platform telah menghilangkan beberapa batasan penting dari model GPGPU sebelumnya yang menggunakan jalur grafis tradisional dan antarmuka Direct3D atau OpenGL yang sesuai.

Tentu saja, standar terbuka yang menggunakan OpenGL tampaknya paling portabel dan universal, mereka memungkinkan Anda untuk menggunakan kode yang sama untuk chip video dari produsen yang berbeda. Tetapi metode seperti itu memiliki banyak kelemahan, mereka kurang fleksibel dan tidak nyaman untuk digunakan. Selain itu, mereka mencegah penggunaan fitur khusus dari kartu video tertentu, seperti memori bersama (bersama) yang cepat yang ada dalam prosesor komputasi modern.

Itulah sebabnya Nvidia merilis platform CUDA, bahasa pemrograman mirip-C dengan kompiler dan pustakanya sendiri untuk komputasi GPU. Tentu saja, menulis kode optimal untuk chip video sama sekali tidak mudah dan tugas ini membutuhkan pekerjaan manual yang lama, tetapi CUDA hanya mengungkapkan semua kemungkinan dan memberi programmer lebih banyak kendali atas kemampuan perangkat keras GPU. Penting agar dukungan Nvidia CUDA tersedia untuk chip G8x, G9x dan GT2xx yang digunakan dalam kartu video seri Geforce 8, 9 dan 200, yang tersebar luas. Versi final CUDA 2.0 kini telah dirilis, yang memiliki beberapa fitur baru, seperti dukungan untuk perhitungan presisi ganda. CUDA tersedia di sistem operasi Linux, Windows, dan MacOS X 32-bit dan 64-bit.

Perbedaan antara CPU dan GPU dalam Komputasi Paralel

Pertumbuhan frekuensi prosesor universal mengalami keterbatasan fisik dan konsumsi daya yang tinggi, dan kinerjanya semakin meningkat karena penempatan beberapa inti dalam satu chip. Prosesor yang dijual sekarang hanya berisi hingga empat inti (pertumbuhan lebih lanjut tidak akan cepat) dan ditujukan untuk aplikasi umum, gunakan MIMD - beberapa instruksi dan aliran data. Setiap inti beroperasi secara terpisah dari yang lain, mengeksekusi instruksi yang berbeda untuk proses yang berbeda.

Kemampuan vektor khusus (SSE2 dan SSE3) untuk vektor 4 komponen (titik-mengambang presisi tunggal) dan dua komponen (presisi ganda) telah muncul di prosesor tujuan umum karena meningkatnya permintaan aplikasi grafis. Itulah sebabnya untuk tugas-tugas tertentu penggunaan GPU lebih menguntungkan, karena pada awalnya dibuat untuk mereka.

Misalnya, dalam chip video Nvidia, unit utamanya adalah multiprosesor dengan delapan hingga sepuluh core dan total ratusan ALU, beberapa ribu register, dan sejumlah kecil shared memory. Selain itu, kartu video berisi memori global cepat yang dapat diakses oleh semua multiprosesor, memori lokal di setiap multiprosesor, dan memori khusus untuk konstanta.

Yang terpenting, beberapa inti multiprosesor di GPU ini adalah inti SIMD (aliran instruksi tunggal, aliran data ganda). Dan inti ini menjalankan instruksi yang sama pada saat yang sama, gaya pemrograman yang umum dalam algoritme grafik dan banyak tugas ilmiah, tetapi memerlukan pemrograman khusus. Tetapi pendekatan ini memungkinkan Anda untuk meningkatkan jumlah unit eksekusi karena penyederhanaannya.

Jadi, mari daftar perbedaan utama antara arsitektur CPU dan GPU. Core CPU dirancang untuk mengeksekusi satu aliran instruksi berurutan dengan kinerja maksimum, sementara GPU dirancang untuk mengeksekusi sejumlah besar aliran instruksi paralel dengan cepat. Prosesor tujuan umum dioptimalkan untuk mencapai kinerja tinggi pada aliran instruksi tunggal yang memproses bilangan bulat dan angka floating point. Akses memori acak.

Perancang CPU mencoba untuk mendapatkan instruksi sebanyak mungkin untuk dieksekusi secara paralel untuk meningkatkan kinerja. Untuk melakukan ini, dimulai dengan prosesor Intel Pentium, eksekusi superskalar muncul, menyediakan eksekusi dua instruksi per jam, dan Pentium Pro membedakan dirinya dengan eksekusi instruksi yang tidak berurutan. Tetapi eksekusi paralel dari aliran instruksi sekuensial memiliki batasan dasar tertentu, dan dengan meningkatkan jumlah unit eksekusi, peningkatan kecepatan berganda tidak dapat dicapai.

Chip video memiliki operasi yang sederhana dan paralel sejak awal. Chip video mengambil sekelompok poligon pada input, melakukan semua operasi yang diperlukan, dan menghasilkan piksel pada output. Pemrosesan poligon dan piksel bersifat independen, mereka dapat diproses secara paralel, terpisah satu sama lain. Oleh karena itu, karena organisasi kerja paralel yang inheren di GPU, sejumlah besar unit eksekusi digunakan, yang mudah dimuat, berbeda dengan aliran instruksi berurutan untuk CPU. Selain itu, GPU modern juga dapat mengeksekusi lebih dari satu instruksi per jam (masalah ganda). Dengan demikian, arsitektur Tesla, dalam kondisi tertentu, meluncurkan operasi MAD+MUL atau MAD+SFU secara bersamaan.

GPU berbeda dari CPU juga dalam hal prinsip akses memori. Di GPU, ini terhubung dan mudah diprediksi - jika texel tekstur dibaca dari memori, maka setelah beberapa saat waktunya akan tiba untuk texel tetangga. Ya, dan saat merekam yang sama - piksel ditulis ke framebuffer, dan setelah beberapa siklus, yang terletak di sebelahnya akan direkam. Oleh karena itu, organisasi memori berbeda dari yang digunakan di CPU. Dan chip video, tidak seperti prosesor universal, sama sekali tidak memerlukan memori cache yang besar, dan tekstur hanya membutuhkan beberapa kilobyte (hingga 128-256 dalam GPU saat ini).

Dan itu sendiri, bekerja dengan memori untuk GPU dan CPU agak berbeda. Jadi, tidak semua CPU memiliki pengontrol memori internal, dan semua GPU biasanya memiliki beberapa pengontrol, hingga delapan saluran 64-bit dalam chip Nvidia GT200. Selain itu, kartu video menggunakan memori yang lebih cepat, dan sebagai hasilnya, chip video memiliki lebih banyak bandwidth memori yang tersedia, yang juga sangat penting untuk perhitungan paralel yang beroperasi dengan aliran data yang besar.

Dalam prosesor tujuan umum, sejumlah besar transistor dan area chip masuk ke buffer instruksi, prediksi cabang perangkat keras, dan sejumlah besar memori cache on-chip. Semua blok perangkat keras ini diperlukan untuk mempercepat eksekusi beberapa aliran instruksi. Chip video menghabiskan transistor pada array unit eksekusi, unit kontrol aliran, memori bersama kecil, dan pengontrol memori multi-saluran. Hal di atas tidak mempercepat eksekusi masing-masing utas, ini memungkinkan chip memproses beberapa ribu utas yang secara bersamaan dieksekusi pada chip dan membutuhkan bandwidth memori yang tinggi.

Tentang perbedaan dalam caching. CPU tujuan umum menggunakan cache untuk meningkatkan kinerja dengan mengurangi latensi akses memori, sementara GPU menggunakan cache atau memori bersama untuk meningkatkan bandwidth. CPU mengurangi latensi akses memori dengan cache besar dan prediksi cabang kode. Potongan perangkat keras ini mengambil sebagian besar area chip dan menghabiskan banyak daya. Chip video mengatasi masalah penundaan akses memori dengan mengeksekusi ribuan utas secara bersamaan - sementara salah satu utas menunggu data dari memori, chip video dapat melakukan perhitungan utas lain tanpa menunggu dan menunda.

Ada banyak perbedaan dalam dukungan multithreading juga. CPU mengeksekusi 1-2 utas komputasi per inti prosesor, dan chip video dapat mendukung hingga 1024 utas per multiprosesor, di mana ada beberapa di dalam chip. Dan jika beralih dari satu utas ke utas lainnya untuk CPU menghabiskan ratusan siklus, maka GPU mengalihkan beberapa utas dalam satu siklus.

Selain itu, CPU menggunakan blok SIMD (instruksi tunggal, banyak data) untuk komputasi vektor, dan GPU menggunakan SIMT (instruksi tunggal, beberapa utas) untuk pemrosesan utas skalar. SIMT tidak mengharuskan pengembang untuk mengubah data menjadi vektor dan memungkinkan percabangan sewenang-wenang dalam aliran.

Singkatnya, kita dapat mengatakan bahwa, tidak seperti CPU universal modern, chip video dirancang untuk komputasi paralel dengan sejumlah besar operasi aritmatika. Dan jumlah transistor GPU yang jauh lebih besar bekerja untuk tujuan yang dimaksudkan - pemrosesan array data, dan tidak mengontrol eksekusi (kontrol aliran) dari beberapa utas komputasi berurutan. Ini adalah diagram berapa banyak ruang di CPU dan GPU membutuhkan berbagai logika:

Akibatnya, dasar untuk penggunaan kekuatan GPU yang efektif dalam perhitungan ilmiah dan non-grafis lainnya adalah paralelisasi algoritme menjadi ratusan unit eksekusi yang tersedia dalam chip video. Misalnya, banyak aplikasi pemodelan molekul sangat cocok untuk perhitungan pada chip video, mereka membutuhkan daya komputasi yang besar dan oleh karena itu nyaman untuk komputasi paralel. Dan penggunaan beberapa GPU memberikan lebih banyak daya komputasi untuk memecahkan masalah tersebut.

Melakukan perhitungan pada GPU menunjukkan hasil yang sangat baik dalam algoritme yang menggunakan pemrosesan data paralel. Yaitu, ketika urutan operasi matematika yang sama diterapkan pada sejumlah besar data. Dalam hal ini, hasil terbaik dicapai jika rasio jumlah instruksi aritmatika dengan jumlah akses memori cukup besar. Ini menempatkan lebih sedikit tuntutan pada kontrol aliran, dan kepadatan matematika yang tinggi dan sejumlah besar data menghilangkan kebutuhan akan cache yang besar, seperti pada CPU.

Sebagai hasil dari semua perbedaan yang dijelaskan di atas, kinerja teoritis chip video secara signifikan melebihi kinerja CPU. Nvidia memberikan grafik pertumbuhan kinerja CPU dan GPU berikut selama beberapa tahun terakhir:

Secara alami, data ini bukan tanpa bagian dari kelicikan. Memang, pada CPU jauh lebih mudah untuk mencapai angka teoretis dalam praktik, dan angka diberikan untuk presisi tunggal dalam kasus GPU, dan untuk presisi ganda dalam kasus CPU. Bagaimanapun, presisi tunggal sudah cukup untuk beberapa tugas paralel, dan perbedaan kecepatan antara prosesor universal dan grafis sangat besar, dan oleh karena itu gim ini layak untuk dinyalakan.

Upaya pertama untuk menerapkan perhitungan pada GPU

Chip video telah digunakan dalam perhitungan matematika paralel untuk waktu yang lama. Upaya pertama pada aplikasi semacam itu sangat primitif dan terbatas pada penggunaan beberapa fitur perangkat keras, seperti rasterisasi dan buffering Z. Tetapi di abad ini, dengan munculnya shader, mereka mulai mempercepat perhitungan matriks. Pada tahun 2003, di SIGGRAPH, bagian terpisah dialokasikan untuk komputasi GPU, dan itu disebut GPGPU (Komputasi Tujuan Umum pada GPU) - komputasi GPU universal).

BrookGPU yang paling terkenal adalah kompiler bahasa pemrograman aliran Brook, yang dirancang untuk melakukan perhitungan non-grafis pada GPU. Sebelum kemunculannya, pengembang yang menggunakan kemampuan chip video untuk perhitungan memilih salah satu dari dua API umum: Direct3D atau OpenGL. Ini sangat membatasi penggunaan GPU, karena grafik 3D menggunakan shader dan tekstur yang tidak perlu diketahui oleh programmer paralel, mereka menggunakan utas dan inti. Brook dapat membantu membuat tugas mereka lebih mudah. Ekstensi streaming ke bahasa C ini, yang dikembangkan di Universitas Stanford, menyembunyikan API 3D dari pemrogram dan menampilkan chip video sebagai koprosesor paralel. Kompilator mem-parsing file .br dengan kode dan ekstensi C++, menghasilkan kode yang ditautkan ke pustaka yang mendukung DirectX, OpenGL, atau x86.

Tentu saja, Brook memiliki banyak kekurangan, yang kami permasalahkan dan yang akan kami bahas lebih detail nanti. Tetapi bahkan penampilannya saja telah menyebabkan gelombang perhatian yang signifikan dari Nvidia dan ATI yang sama ke inisiatif komputasi GPU, karena pengembangan kemampuan ini secara serius mengubah pasar di masa depan, membuka sektor yang sama sekali baru - komputasi paralel berdasarkan chip video.

Selanjutnya, beberapa peneliti dari proyek Brook bergabung dengan tim pengembangan Nvidia untuk memperkenalkan strategi komputasi paralel perangkat keras-perangkat lunak, membuka pangsa pasar baru. Dan keuntungan utama dari inisiatif Nvidia ini adalah pengembang mengetahui dengan sempurna semua kemampuan GPU mereka hingga detail terkecil, dan tidak perlu menggunakan API grafis, dan Anda dapat bekerja dengan perangkat keras secara langsung menggunakan driver. Hasil dari upaya tim ini adalah Nvidia CUDA (Compute Unified Device Architecture), arsitektur perangkat keras dan perangkat lunak baru untuk komputasi paralel pada GPU Nvidia, yang menjadi pokok bahasan artikel ini.

Area penerapan komputasi paralel pada GPU

Untuk memahami keuntungan apa yang dibawa oleh transfer perhitungan ke chip video, kami akan menyajikan angka rata-rata yang diperoleh oleh para peneliti di seluruh dunia. Rata-rata, saat mentransfer perhitungan ke GPU, dalam banyak tugas, akselerasi dicapai 5-30 kali lipat dibandingkan dengan prosesor universal yang cepat. Angka terbesar (dari urutan kecepatan 100x dan bahkan lebih!) dicapai pada kode yang tidak terlalu cocok untuk perhitungan menggunakan blok SSE, tetapi cukup nyaman untuk GPU.

Ini hanya beberapa contoh percepatan kode sintetis pada GPU versus kode vektor SSE pada CPU (menurut Nvidia):

- Mikroskop fluoresensi: 12x;

- Dinamika molekul (kalkulasi gaya tak terikat): 8-16x;

- Elektrostatika (penjumlahan Coulomb langsung dan multi-level): 40-120x dan 7x.

Dan ini adalah piring yang sangat disukai Nvidia, menunjukkannya di semua presentasi, yang akan kita bahas secara lebih rinci di bagian kedua artikel, yang dikhususkan untuk contoh spesifik aplikasi praktis komputasi CUDA:

Seperti yang Anda lihat, jumlahnya sangat menarik, terutama keuntungan 100-150 kali lipat yang mengesankan. Dalam artikel CUDA berikutnya, kita akan melihat lebih dekat beberapa angka ini. Dan sekarang kami membuat daftar aplikasi utama di mana komputasi GPU sekarang digunakan: analisis dan pemrosesan gambar dan sinyal, simulasi fisika, matematika komputasi, biologi komputasi, perhitungan keuangan, database, dinamika gas dan cairan, kriptografi, terapi radiasi adaptif, astronomi , pemrosesan suara, bioinformatika, simulasi biologi, visi komputer, penambangan data, sinema digital dan televisi, simulasi elektromagnetik, sistem informasi geografis, aplikasi militer, perencanaan penambangan, dinamika molekul, pencitraan resonansi magnetik (MRI), jaringan saraf, penelitian oseanografi, partikel fisika, simulasi pelipatan protein, kimia kuantum, ray tracing, pencitraan, radar, simulasi reservoir, kecerdasan buatan, analisis data satelit, eksplorasi seismik, pembedahan, ultrasound, konferensi video.

Detail dari banyak aplikasi dapat ditemukan di situs web Nvidia di bagian . Seperti yang Anda lihat, daftarnya cukup besar, tapi bukan itu saja! Ini dapat dilanjutkan, dan kita pasti dapat berasumsi bahwa di masa depan area lain dari penerapan perhitungan paralel pada chip video akan ditemukan, yang masih belum kita ketahui.

Kemampuan Nvidia CUDA

Teknologi CUDA adalah arsitektur komputasi perangkat lunak dan perangkat keras Nvidia berdasarkan ekstensi bahasa C, yang memungkinkan untuk mengakses set instruksi akselerator grafis dan mengelola memorinya dalam komputasi paralel. CUDA membantu mengimplementasikan algoritme yang dapat diimplementasikan pada prosesor grafis akselerator video Geforce generasi kedelapan dan yang lebih lama (seri Geforce 8, Geforce 9, Geforce 200), serta Quadro dan Tesla.

Meskipun kompleksitas pemrograman GPU dengan CUDA cukup tinggi, namun lebih rendah dibandingkan dengan solusi GPGPU awal. Program tersebut memerlukan partisi aplikasi di beberapa multiprosesor yang mirip dengan pemrograman MPI, tetapi tanpa berbagi data yang disimpan dalam memori video bersama. Dan karena pemrograman CUDA untuk setiap multiprosesor mirip dengan pemrograman OpenMP, maka diperlukan pemahaman yang baik tentang organisasi memori. Namun, tentu saja, kerumitan pengembangan dan porting ke CUDA sangat bergantung pada aplikasinya.

Kit pengembang berisi banyak contoh kode dan didokumentasikan dengan baik. Proses pembelajaran akan memakan waktu sekitar dua hingga empat minggu bagi mereka yang sudah terbiasa dengan OpenMP dan MPI. API didasarkan pada bahasa C yang diperluas, dan untuk menerjemahkan kode dari bahasa ini, CUDA SDK menyertakan kompiler baris perintah nvcc, berdasarkan kompiler Open64 terbuka.

Kami mencantumkan karakteristik utama CUDA:

- solusi perangkat lunak dan perangkat keras terpadu untuk komputasi paralel pada chip video Nvidia;

- berbagai solusi yang didukung, dari seluler hingga multi-chip

- bahasa pemrograman C standar;

- pustaka standar untuk analisis numerik FFT (Fast Fourier Transform) dan BLAS (Aljabar Linier);

- pertukaran data yang dioptimalkan antara CPU dan GPU;

- interaksi dengan API grafis OpenGL dan DirectX;

- dukungan untuk sistem operasi 32- dan 64-bit: Windows XP, Windows Vista, Linux dan MacOS X;

- kemampuan untuk berkembang pada tingkat yang rendah.

Mengenai dukungan sistem operasi, harus ditambahkan bahwa semua distribusi Linux utama secara resmi didukung (Red Hat Enterprise Linux 3.x/4.x/5.x, SUSE Linux 10.x), tetapi, menurut para penggemar, CUDA berfungsi dengan baik di build lain: Fedora Core, Ubuntu, Gentoo, dll.

Lingkungan Pengembangan CUDA (CUDA Toolkit) meliputi:

- kompiler nvcc;

- perpustakaan FFT dan BLAS;

- pembuat profil;

- debugger gdb untuk GPU;

- Driver runtime CUDA disertakan dengan driver Nvidia standar

- panduan pemrograman;

- CUDA Developer SDK (kode sumber, utilitas, dan dokumentasi).

Dalam contoh kode sumber: penyortiran bitonic paralel (pengurutan bitonic), transposisi matriks, penjumlahan awalan paralel dari array besar, konvolusi gambar, transformasi wavelet diskrit, contoh interaksi dengan OpenGL dan Direct3D, penggunaan pustaka CUBLAS dan Cufft, perhitungan harga opsi ( Black-Scholes, model binomial, metode Monte Carlo), generator bilangan acak paralel Mersenne Twister, perhitungan histogram array besar, pengurangan noise, filter Sobel (deteksi terikat).

Manfaat dan Keterbatasan CUDA

Dari sudut pandang programmer, pipa grafis adalah serangkaian tahapan pemrosesan. Blok geometri menghasilkan segitiga, dan blok rasterisasi menghasilkan piksel yang ditampilkan di monitor. Model pemrograman GPGPU tradisional adalah sebagai berikut:

Untuk mentransfer komputasi ke GPU dalam kerangka model seperti itu, diperlukan pendekatan khusus. Bahkan penambahan elemen demi elemen dari dua vektor akan membutuhkan menggambar bentuk ke layar atau ke buffer di luar layar. Angka tersebut dirasterisasi, warna setiap piksel dihitung sesuai dengan program yang diberikan (pixel shader). Program membaca data input dari tekstur untuk setiap piksel, menambahkannya, dan menulisnya ke buffer output. Dan semua banyak operasi ini diperlukan untuk apa yang ditulis dalam satu operator dalam bahasa pemrograman konvensional!

Oleh karena itu, penggunaan GPGPU untuk komputasi tujuan umum memiliki keterbatasan berupa terlalu banyak kerumitan untuk dipelajari oleh pengembang. Dan ada batasan lain yang cukup, karena pixel shader hanyalah formula untuk ketergantungan warna akhir piksel pada koordinatnya, dan bahasa pixel shader adalah bahasa untuk menulis formula ini dengan sintaks seperti C. Metode GPGPU awal adalah trik cerdas untuk memanfaatkan kekuatan GPU, tetapi tanpa kenyamanan apa pun. Data yang ada direpresentasikan dengan gambar (tekstur), dan algoritma direpresentasikan dengan proses rasterisasi. Perlu dicatat dan model yang sangat spesifik dari memori dan eksekusi.

Arsitektur perangkat keras dan perangkat lunak Nvidia untuk komputasi pada GPU dari Nvidia berbeda dari model GPGPU sebelumnya karena memungkinkan penulisan program untuk GPU dalam C nyata dengan sintaks standar, pointer, dan kebutuhan akan ekstensi minimum untuk mengakses sumber daya komputasi chip video. CUDA tidak bergantung pada API grafis, dan memiliki beberapa fitur yang dirancang khusus untuk komputasi tujuan umum.

Keuntungan CUDA dibandingkan pendekatan tradisional untuk komputasi GPGPU:

- antarmuka pemrograman aplikasi CUDA didasarkan pada bahasa pemrograman C standar dengan ekstensi, yang menyederhanakan proses pembelajaran dan penerapan arsitektur CUDA;

- CUDA menyediakan akses ke 16 KB memori bersama per multiprosesor, yang dapat digunakan untuk mengatur cache dengan bandwidth yang lebih tinggi daripada pengambilan tekstur;

- transfer data yang lebih efisien antara sistem dan memori video

- tidak perlu API grafis dengan redundansi dan overhead;

- pengalamatan memori linier, dan mengumpulkan dan menyebarkan, kemampuan untuk menulis ke alamat sewenang-wenang;

- dukungan perangkat keras untuk operasi integer dan bit.

Keterbatasan utama CUDA:

- kurangnya dukungan rekursi untuk fungsi yang dapat dieksekusi;

- lebar blok minimum adalah 32 utas;

- arsitektur CUDA eksklusif yang dimiliki oleh Nvidia.

Kelemahan pemrograman dengan metode GPGPU sebelumnya adalah metode ini tidak menggunakan unit eksekusi vertex shader pada arsitektur non-unified sebelumnya, data disimpan dalam tekstur dan output ke buffer off-screen, dan algoritma multi-pass menggunakan unit pixel shader. Keterbatasan GPGPU meliputi: penggunaan kemampuan perangkat keras yang tidak cukup efisien, keterbatasan bandwidth memori, tidak ada operasi pencar (hanya pengumpulan), penggunaan wajib API grafis.

Keuntungan utama CUDA dibandingkan metode GPGPU sebelumnya berasal dari fakta bahwa arsitektur ini dirancang untuk secara efisien menggunakan komputasi non-grafis pada GPU dan menggunakan bahasa pemrograman C tanpa memerlukan algoritme untuk porting ke bentuk yang sesuai untuk konsep grafis. pipa. CUDA menawarkan jalur komputasi GPU baru yang tidak menggunakan API grafis, menawarkan akses memori acak (menyebarkan atau mengumpulkan). Arsitektur seperti itu bebas dari kelemahan GPGPU dan menggunakan semua unit eksekusi, dan juga memperluas kemampuan melalui matematika bilangan bulat dan operasi pergeseran bit.

Selain itu, CUDA membuka beberapa fitur perangkat keras yang tidak tersedia dari API grafis, seperti memori bersama. Ini adalah sejumlah kecil memori (16 kilobyte per multiprosesor) yang dapat diakses oleh blok utas. Ini memungkinkan Anda untuk men-cache data yang paling sering diakses dan dapat memberikan kinerja yang lebih cepat daripada menggunakan pengambilan tekstur untuk tugas ini. Ini, pada gilirannya, mengurangi sensitivitas throughput dari algoritma paralel di banyak aplikasi. Misalnya, berguna untuk aljabar linier, transformasi Fourier cepat, dan filter pemrosesan gambar.

Lebih nyaman di CUDA dan akses memori. Kode dalam API grafis mengeluarkan data sebagai 32 nilai floating-point presisi tunggal (nilai RGBA secara bersamaan ke delapan target render) di area yang telah ditentukan, dan CUDA mendukung perekaman sebar - jumlah catatan yang tidak terbatas di alamat mana pun. Keunggulan tersebut memungkinkan untuk mengeksekusi beberapa algoritma pada GPU yang tidak dapat diimplementasikan secara efisien menggunakan metode GPGPU berdasarkan API grafis.

Juga, API grafis harus menyimpan data dalam tekstur, yang membutuhkan pengemasan sebelumnya dari array besar ke dalam tekstur, yang memperumit algoritme dan memaksa penggunaan pengalamatan khusus. Dan CUDA memungkinkan Anda membaca data di alamat mana pun. Keuntungan lain dari CUDA adalah komunikasi yang dioptimalkan antara CPU dan GPU. Dan untuk pengembang yang ingin mengakses level rendah (misalnya, saat menulis bahasa pemrograman lain), CUDA menawarkan kemungkinan pemrograman bahasa assembly level rendah.

Sejarah perkembangan CUDA

Pengembangan CUDA diumumkan dengan chip G80 pada November 2006, dan versi beta publik dari CUDA SDK dirilis pada Februari 2007. Versi 1.0 dirilis pada Juni 2007 untuk meluncurkan solusi Tesla berdasarkan chip G80 untuk pasar komputasi kinerja tinggi. Kemudian, pada akhir tahun, CUDA 1.1 beta dirilis, yang meskipun sedikit meningkat dalam jumlah versi, memperkenalkan cukup banyak hal baru.

Dari apa yang muncul di CUDA 1.1, kami dapat mencatat penyertaan fungsionalitas CUDA di driver video Nvidia biasa. Ini berarti bahwa dalam persyaratan untuk program CUDA apa pun, cukup untuk menentukan kartu video seri Geforce 8 dan lebih tinggi, serta versi driver minimum 169.xx. Ini sangat penting bagi pengembang, jika kondisi ini terpenuhi, program CUDA akan berfungsi untuk pengguna mana pun. Selain itu, eksekusi asinkron ditambahkan bersama dengan penyalinan data (hanya untuk G84, G86, G92 dan chip yang lebih tinggi), transfer data asinkron ke memori video, operasi akses memori atom, dukungan untuk Windows versi 64-bit, dan kemungkinan multi -operasi CUDA chip dalam mode SLI.

Saat ini, versi untuk solusi berbasis GT200 adalah CUDA 2.0, yang dirilis bersama dengan lini Geforce GTX 200. Versi beta dirilis pada musim semi 2008. Versi kedua memiliki: dukungan untuk perhitungan presisi ganda (hanya dukungan perangkat keras untuk GT200), Windows Vista (versi 32 dan 64-bit) dan Mac OS X akhirnya didukung, alat debugging dan profil telah ditambahkan, tekstur 3D didukung, dioptimalkan transfer data.

Sedangkan untuk perhitungan dengan presisi ganda, kecepatannya pada generasi perangkat keras saat ini beberapa kali lebih rendah daripada presisi tunggal. Alasan dibahas di kami. Implementasi dukungan ini di GT200 terletak pada kenyataan bahwa blok FP32 tidak digunakan untuk mendapatkan hasil dengan kecepatan empat kali lebih lambat, untuk mendukung perhitungan FP64, Nvidia memutuskan untuk membuat blok komputasi khusus. Dan di GT200 jumlahnya sepuluh kali lebih sedikit daripada blok FP32 (satu blok presisi ganda untuk setiap multiprosesor).

Kenyataannya, kinerjanya bisa lebih rendah lagi, karena arsitekturnya dioptimalkan untuk pembacaan 32-bit dari memori dan register, selain itu, presisi ganda tidak diperlukan dalam aplikasi grafis, dan di GT200 itu dibuat lebih mungkin. Ya, dan prosesor quad-core modern menunjukkan kinerja yang tidak kalah nyata. Tetapi bahkan 10 kali lebih lambat dari presisi tunggal, dukungan ini berguna untuk sirkuit presisi campuran. Salah satu teknik umum adalah untuk mendapatkan hasil perkiraan awalnya dalam presisi tunggal, dan kemudian memperbaikinya dalam presisi ganda. Sekarang ini dapat dilakukan langsung pada kartu video, tanpa mengirimkan data perantara ke CPU.

Fitur lain yang berguna dari CUDA 2.0 tidak ada hubungannya dengan GPU, anehnya. Sekarang mungkin untuk mengkompilasi kode CUDA menjadi kode SSE multi-utas yang sangat efisien untuk eksekusi cepat pada CPU. Artinya, sekarang fitur ini cocok tidak hanya untuk debugging, tetapi juga untuk penggunaan nyata pada sistem tanpa kartu video Nvidia. Bagaimanapun, penggunaan CUDA dalam kode normal dibatasi oleh fakta bahwa kartu video Nvidia, meskipun yang paling populer di antara solusi video khusus, tidak tersedia di semua sistem. Dan sebelum versi 2.0, dalam kasus seperti itu, dua kode berbeda harus ditulis: untuk CUDA dan secara terpisah untuk CPU. Dan sekarang Anda dapat menjalankan program CUDA apa pun pada CPU dengan efisiensi tinggi, meskipun pada kecepatan yang lebih rendah daripada pada chip video.

Solusi yang Didukung Nvidia CUDA

Semua kartu grafis berkemampuan CUDA dapat membantu mempercepat tugas yang paling menuntut, mulai dari pemrosesan audio dan video hingga penelitian medis dan ilmiah. Satu-satunya batasan nyata adalah bahwa banyak program CUDA memerlukan minimal 256 megabyte memori video, dan ini adalah salah satu spesifikasi paling penting untuk aplikasi CUDA.

Daftar terbaru produk yang mendukung CUDA dapat ditemukan di . Pada saat penulisan ini, perhitungan CUDA mendukung semua produk seri Geforce 200, Geforce 9 dan Geforce 8, termasuk produk seluler, dimulai dengan Geforce 8400M, serta chipset Geforce 8100, 8200, dan 8300. Quadro modern dan semua Tesla: S1070, C1060, C870, D870 dan S870.

Kami secara khusus mencatat bahwa bersama dengan kartu video Geforce GTX 260 dan 280 yang baru, solusi komputasi kinerja tinggi yang sesuai diumumkan: Tesla C1060 dan S1070 (ditunjukkan pada foto di atas), yang akan tersedia untuk pembelian musim gugur ini. GPU yang sama digunakan di dalamnya - GT200, di C1060 itu satu, di S1070 - empat. Namun, tidak seperti solusi game, mereka menggunakan empat gigabyte memori per chip. Dari kekurangannya, mungkin frekuensi memori dan bandwidth memori yang lebih rendah daripada kartu game, menyediakan 102 gigabyte / s per chip.

Komposisi Nvidia CUDA

CUDA mencakup dua API: tingkat tinggi (CUDA Runtime API) dan tingkat rendah (CUDA Driver API), meskipun tidak mungkin untuk menggunakan keduanya secara bersamaan dalam satu program, Anda harus menggunakan satu atau yang lain. Yang tingkat tinggi bekerja "di atas" dari yang tingkat rendah, semua panggilan runtime diterjemahkan ke dalam instruksi sederhana yang diproses oleh API Driver tingkat rendah. Tetapi bahkan API "tingkat tinggi" mengasumsikan pengetahuan tentang desain dan pengoperasian chip video Nvidia; tidak ada tingkat abstraksi yang terlalu tinggi di sana.

Ada level lain, bahkan lebih tinggi - dua perpustakaan:

CUBLAS- Versi CUDA dari BLAS (Subprogram Aljabar Linier Dasar), dirancang untuk menghitung masalah aljabar linier dan menggunakan akses langsung ke sumber daya GPU;

manset- Versi CUDA dari pustaka Fast Fourier Transform untuk menghitung Fast Fourier Transform, banyak digunakan dalam pemrosesan sinyal. Jenis transformasi berikut didukung: kompleks-kompleks (C2C), real-kompleks (R2C), dan kompleks-nyata (C2R).

Mari kita lihat lebih dekat perpustakaan ini. CUBLAS adalah algoritma aljabar linier standar yang diterjemahkan ke dalam bahasa CUDA, saat ini hanya beberapa fungsi dasar CUBLAS yang didukung. Pustaka ini sangat mudah digunakan: Anda perlu membuat objek matriks dan vektor dalam memori video, mengisinya dengan data, memanggil fungsi CUBLAS yang diperlukan, dan memuat kembali hasil dari memori video ke dalam memori sistem. CUBLAS berisi fungsi khusus untuk membuat dan menghancurkan objek di memori GPU, serta untuk membaca dan menulis data ke memori ini. Fungsi BLAS yang didukung: level 1, 2 dan 3 untuk bilangan real, level 1 CGEMM untuk kompleks. Level 1 adalah operasi vektor-vektor, level 2 adalah operasi matriks-vektor, level 3 adalah operasi matriks-matriks.

Cufft - varian CUDA dari Fast Fourier Transform - banyak digunakan dan sangat penting dalam analisis sinyal, penyaringan, dll. Cufft menyediakan antarmuka sederhana untuk komputasi FFT yang efisien pada GPU Nvidia tanpa perlu mengembangkan FFT khusus untuk GPU. Varian CUDA FFT mendukung transformasi 1D, 2D, dan 3D dari data yang kompleks dan nyata, eksekusi batch untuk beberapa transformasi 1D secara paralel, ukuran transformasi 2D dan 3D dapat berada di dalam , untuk 1D ukuran hingga 8 juta elemen didukung.

Dasar-dasar membuat program di CUDA

Untuk memahami teks di bawah ini, Anda harus memahami fitur arsitektur dasar chip video Nvidia. GPU terdiri dari beberapa cluster unit tekstur (Texture Processing Cluster). Setiap cluster terdiri dari blok pengambilan tekstur yang diperbesar dan dua atau tiga multiprosesor streaming, yang masing-masing terdiri dari delapan perangkat komputasi dan dua blok superfungsional. Semua instruksi dieksekusi sesuai dengan prinsip SIMD, ketika satu instruksi diterapkan ke semua utas dalam warp (istilah dari industri tekstil, di CUDA ini adalah sekelompok 32 utas - jumlah minimum data yang diproses oleh multiprosesor). Metode eksekusi ini disebut SIMT (satu instruksi banyak utas - satu instruksi dan banyak utas).

Setiap multiprosesor memiliki sumber daya tertentu. Jadi, ada memori bersama khusus dengan kapasitas 16 kilobyte per multiprosesor. Tetapi ini bukan cache, karena programmer dapat menggunakannya untuk kebutuhan apa pun, mirip dengan Penyimpanan Lokal di SPU prosesor Sel. Memori bersama ini memungkinkan pertukaran informasi antara utas dari blok yang sama. Adalah penting bahwa semua utas dari satu blok selalu dieksekusi oleh multiprosesor yang sama. Dan utas dari blok yang berbeda tidak dapat bertukar data, dan Anda harus mengingat batasan ini. Memori bersama seringkali berguna, kecuali ketika beberapa utas mengakses bank memori yang sama. Multiprosesor juga dapat mengakses memori video, tetapi dengan latensi yang lebih tinggi dan bandwidth yang lebih rendah. Untuk mempercepat akses dan mengurangi frekuensi mengakses memori video, multiprosesor memiliki 8 kilobyte cache untuk konstanta dan data tekstur.

Multiprosesor menggunakan 8192-16384 (untuk G8x/G9x dan GT2xx, masing-masing) register umum untuk semua utas dari semua blok yang mengeksekusinya. Jumlah maksimum blok per multiprosesor untuk G8x/G9x adalah delapan, dan jumlah warps adalah 24 (768 utas per multiprosesor). Secara total, kartu video teratas dari seri Geforce 8 dan 9 dapat memproses hingga 12288 utas sekaligus. GeForce GTX 280 berdasarkan GT200 menawarkan hingga 1024 thread per multiprosesor, ia memiliki 10 cluster dari tiga multiprosesor yang memproses hingga 30720 thread. Mengetahui batasan ini memungkinkan Anda mengoptimalkan algoritme untuk sumber daya yang tersedia.

Langkah pertama dalam mem-porting aplikasi yang ada ke CUDA adalah membuat profilnya dan mengidentifikasi area kode yang merupakan hambatan yang memperlambat kerja. Jika di antara bagian-bagian tersebut ada yang cocok untuk eksekusi paralel cepat, fungsi-fungsi ini ditransfer ke ekstensi C dan CUDA untuk dieksekusi pada GPU. Program ini dikompilasi menggunakan compiler yang disediakan Nvidia, yang menghasilkan kode untuk CPU dan GPU. Ketika sebuah program dijalankan, CPU mengeksekusi bagian kodenya, dan GPU mengeksekusi kode CUDA dengan komputasi paralel terberat. Bagian ini, dirancang untuk GPU, disebut kernel (kernel). Kernel mendefinisikan operasi yang akan dilakukan pada data.

Chip video menerima inti dan membuat salinan untuk setiap elemen data. Salinan ini disebut utas. Sebuah stream berisi counter, register, dan state. Untuk data dalam jumlah besar, seperti pemrosesan gambar, jutaan utas diluncurkan. Utas berjalan dalam kelompok 32 yang disebut warps. Warps ditugaskan untuk berjalan pada multiprosesor streaming tertentu. Setiap multiprosesor terdiri dari delapan inti - prosesor aliran yang mengeksekusi satu instruksi MAD per siklus clock. Untuk mengeksekusi satu warp 32-utas, diperlukan empat siklus multiprosesor (kita berbicara tentang frekuensi domain shader, yaitu 1,5 GHz dan lebih tinggi).

Multiprosesor bukanlah prosesor multi-core tradisional, ini sangat cocok untuk multi-threading, mendukung hingga 32 warps pada satu waktu.Setiap siklus clock, perangkat keras memilih warps mana yang akan dieksekusi, dan beralih dari satu ke yang lain tanpa kehilangan siklus. Jika kita menggambar analogi dengan prosesor pusat, ini seperti menjalankan 32 program pada saat yang sama dan beralih di antara mereka setiap siklus jam tanpa kehilangan sakelar konteks. Pada kenyataannya, inti CPU mendukung eksekusi simultan dari satu program dan beralih ke yang lain dengan penundaan ratusan siklus.

Model Pemrograman CUDA

Sekali lagi, CUDA menggunakan model komputasi paralel, di mana masing-masing prosesor SIMD mengeksekusi instruksi yang sama pada item data yang berbeda secara paralel. GPU adalah perangkat komputasi, coprocessor (perangkat) untuk prosesor pusat (host), yang memiliki memori sendiri dan memproses sejumlah besar utas secara paralel. Kernel (kernel) adalah fungsi untuk GPU, dijalankan oleh utas (analogi dari grafik 3D - shader).

Kami mengatakan di atas bahwa chip video berbeda dari CPU karena dapat memproses puluhan ribu utas secara bersamaan, yang biasanya untuk grafik yang diparalelkan dengan baik. Setiap aliran adalah skalar, tidak memerlukan data untuk dikemas ke dalam vektor 4 komponen, yang lebih nyaman untuk sebagian besar tugas. Jumlah utas logis dan blok utas melebihi jumlah unit eksekusi fisik, yang memberikan skalabilitas yang baik untuk seluruh rentang solusi perusahaan.

Model pemrograman di CUDA mengasumsikan pengelompokan thread. Utas digabungkan menjadi blok utas - kisi satu atau dua dimensi dari utas yang berinteraksi satu sama lain menggunakan memori bersama dan titik sinkronisasi. Program (kernel) dijalankan di atas kotak blok utas, lihat gambar di bawah. Satu grid dieksekusi pada waktu yang sama. Setiap blok dapat berbentuk satu, dua, atau tiga dimensi, dan dapat terdiri dari 512 utas pada perangkat keras saat ini.

Blok utas berjalan dalam kelompok kecil yang disebut warps, yang berukuran 32 utas. Ini adalah jumlah minimum data yang dapat diproses dalam multiprosesor. Dan karena ini tidak selalu nyaman, CUDA memungkinkan Anda untuk bekerja dengan blok yang berisi 64 hingga 512 utas.

Mengelompokkan blok ke dalam kisi memungkinkan Anda untuk keluar dari batasan dan menerapkan kernel ke sejumlah besar utas dalam satu panggilan. Ini juga membantu dengan penskalaan. Jika GPU tidak memiliki sumber daya yang cukup, ia akan mengeksekusi blok secara berurutan. Jika tidak, blok dapat dieksekusi secara paralel, yang penting untuk distribusi kerja yang optimal pada chip video dari berbagai level, mulai dari yang seluler dan terintegrasi.

Model memori CUDA

Model memori di CUDA dibedakan oleh kemungkinan pengalamatan byte, dukungan untuk pengumpulan dan pencar. Jumlah register yang cukup besar tersedia untuk setiap stream processor, hingga 1024 buah. Akses ke mereka sangat cepat, Anda dapat menyimpan bilangan bulat 32-bit atau angka floating point di dalamnya.

Setiap utas memiliki akses ke jenis memori berikut:

memori global- jumlah memori terbesar yang tersedia untuk semua multiprosesor pada chip video, ukurannya berkisar dari 256 megabyte hingga 1,5 gigabyte untuk solusi saat ini (dan hingga 4 GB untuk Tesla). Ini memiliki throughput yang tinggi, lebih dari 100 gigabyte / s untuk solusi Nvidia teratas, tetapi penundaan yang sangat besar hingga beberapa ratus siklus. Tidak dapat di-cache, mendukung instruksi pemuatan dan penyimpanan umum, dan pointer memori biasa.

memori lokal adalah sejumlah kecil memori yang hanya dapat diakses oleh satu prosesor aliran. Ini relatif lambat - sama dengan yang global.

Berbagi memori adalah blok memori 16-kilobyte (dalam chip video arsitektur saat ini) dengan akses bersama untuk semua prosesor aliran dalam multiprosesor. Memori ini sangat cepat, sama seperti register. Ini menyediakan interaksi utas, dikelola langsung oleh pengembang, dan memiliki latensi rendah. Keuntungan dari memori bersama: digunakan dalam bentuk cache tingkat pertama yang dikelola oleh programmer, mengurangi penundaan pengaksesan data oleh unit eksekusi (ALU), mengurangi jumlah akses memori global.

Memori konstan- area memori 64 kilobyte (sama untuk GPU saat ini), hanya-baca oleh semua multiprosesor. Itu di-cache pada 8 kilobyte per multiprosesor. Cukup lambat - penundaan beberapa ratus siklus tanpa adanya data yang diperlukan dalam cache.

memori tekstur- blok memori yang tersedia untuk dibaca oleh semua multiprosesor. Pengambilan sampel data dilakukan dengan menggunakan unit tekstur chip video, sehingga kemungkinan interpolasi data linier disediakan tanpa biaya tambahan. 8 kilobyte di-cache per multiprosesor. Lambat seperti global - ratusan siklus penundaan karena tidak adanya data dalam cache.